边缘检测

边缘检测的原理是利用一些边缘检测算子对图像进行卷积(convolution)操作。

什么是卷积

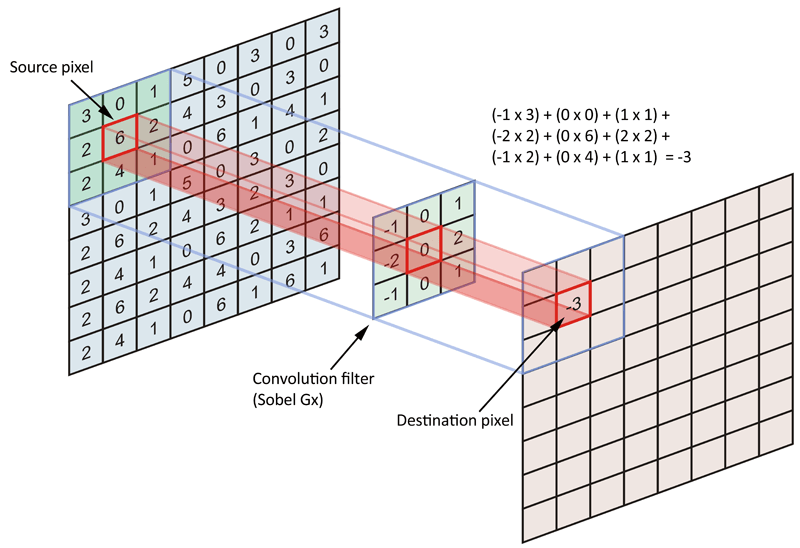

在图像处理中,卷积操作指的就是使用一个卷积核(kernel)对一张图像中的每个像素进行一系列操作。卷积核通常是一个四方形网格状结构,该区域内每个方格都有一个权重值。当对图像中的某个像素进行卷积时会把卷积核的中心放置于该像素上,翻转核之后再依次计算核中每个元素和其覆盖的图像像素值的乘积并求和,得到的结果就是该位置的新像素值。

在二维图像上,使用Sobel Gx滤波器进行卷积.

常见的边缘检测算子

如果相邻像素之间存在差别明显的颜色、亮度、纹理等属性,我们就会认为它们之间应该有一条边界。这种相邻像素之间的差值可以用梯度(gradient)来表示,可以想象得到,边缘处的梯度绝对值比较大。基于这样的理解,有几种不同的边缘检测算子被先后提出来。分别是Roberts、Prewitt、Sobel。

高级边缘检测

直接利用颜色信息进行边缘检测的方法会产生很多我们不希望得到的边缘线。物体的纹理、阴影等位置也被描上黑边。

下面介绍如何在深度和法线纹理上进行边缘检测,这些图像不会受到纹理和光照的影响,而仅仅保存了当前渲染物体的模型信息,通过这样的方式检测出来的边缘更加可靠。

使用Sobel算子进行边缘检测。Sobel算子的本质就是计算左上角和右下角差值,乘以右上角和左下角的差值,作为评估边缘的依据。在下面的实现中,按照这样的方式,取对角方向的深度或法线值,比较它们之间的差值,如果超过某个阈值(可由参数控制),就认为它们之间存在一条边。

首先编写EdgeDetectNormalsAndDepth.cs

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

using UnityEngine;

using System.Collections;

//1.继承创建的基类

public class EdgeDetection : PostEffectsBase {

//声明该效果需要的Shader,并据此创建相应的材质

public Shader edgeDetectShader;

private Material edgeDetectMaterial = null;

public Material material {

get {

edgeDetectMaterial = CheckShaderAndCreateMaterial(edgeDetectShader, edgeDetectMaterial);

return edgeDetectMaterial;

}

}

//在脚本中提供了调整边缘线强度描边颜色以及背景颜色参数。

//同时添加了控制采样距离以及对深度和法线进行边缘检测时的灵敏度参数

[Range(0.0f, 1.0f)]

public float edgesOnly = 0.0f;

public Color edgeColor = Color.black;

public Color backgroundColor = Color.white;

public float sampleDistance = 1.0f;

public float sensitivityDepth = 1.0f;

public float sensitivityNormals = 1.0f;

//获取摄像机的深度+法线纹理,在脚本的OnEnable函数中设置摄像机的相应状态

void OnEnable()

{

GetComponent<Camera>().depthTextureMode |= DepthTextureMode.DepthNormals;

}

//实现OnRenderImage函数,把各个参数传递给材质

[ImageEffectOpaque]

void OnRenderImage (RenderTexture src, RenderTexture dest) {

if (material != null) {

material.SetFloat("_EdgeOnly", edgesOnly);

material.SetColor("_EdgeColor", edgeColor);

material.SetColor("_BackgroundColor", backgroundColor);

material.SetFloat("_SampleDistance", sampleDistance);

material.SetVector("_Sensitivity", new Vector4(sensitivityNormals, sensitivityDepth, 0.0f, 0.0f));

Graphics.Blit(src, dest, material);

} else {

Graphics.Blit(src, dest);

}

}

}

需要注意的是,这里为OnRenderImage函数添加了[ImageEffectOpaque]属性。[ImageEffectOpaque]属性对渲染队列小于等于2500的Pass会执行,也就是只对不透明物体描边,透明物体不描边

下面实现Shader部分

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

// Upgrade NOTE: replaced 'mul(UNITY_MATRIX_MVP,*)' with 'UnityObjectToClipPos(*)'

Shader "Unity Shaders Book/Chapter 13/Edge Detection Normals And Depth" {

Properties {

_MainTex ("Base (RGB)", 2D) = "white" {}

_EdgeOnly ("Edge Only", Float) = 1.0

_EdgeColor ("Edge Color", Color) = (0, 0, 0, 1)

_BackgroundColor ("Background Color", Color) = (1, 1, 1, 1)

_SampleDistance ("Sample Distance", Float) = 1.0

_Sensitivity ("Sensitivity", Vector) = (1, 1, 1, 1)

}

SubShader {

CGINCLUDE

#include "UnityCG.cginc"

sampler2D _MainTex;

half4 _MainTex_TexelSize;

fixed _EdgeOnly;

fixed4 _EdgeColor;

fixed4 _BackgroundColor;

float _SampleDistance;

half4 _Sensitivity;

sampler2D _CameraDepthNormalsTexture;

struct v2f {

float4 pos : SV_POSITION;

half2 uv[5]: TEXCOORD0;

};

v2f vert(appdata_img v) {

v2f o;

o.pos = UnityObjectToClipPos(v.vertex);

half2 uv = v.texcoord;

o.uv[0] = uv;

#if UNITY_UV_STARTS_AT_TOP

if (_MainTex_TexelSize.y < 0)

uv.y = 1 - uv.y;

#endif

o.uv[1] = uv + _MainTex_TexelSize.xy * half2(1,1) * _SampleDistance;

o.uv[2] = uv + _MainTex_TexelSize.xy * half2(-1,-1) * _SampleDistance;

o.uv[3] = uv + _MainTex_TexelSize.xy * half2(-1,1) * _SampleDistance;

o.uv[4] = uv + _MainTex_TexelSize.xy * half2(1,-1) * _SampleDistance;

return o;

}

half CheckSame(half4 center, half4 sample) {

half2 centerNormal = center.xy;

float centerDepth = DecodeFloatRG(center.zw);

half2 sampleNormal = sample.xy;

float sampleDepth = DecodeFloatRG(sample.zw);

// difference in normals

// do not bother decoding normals - there's no need here

half2 diffNormal = abs(centerNormal - sampleNormal) * _Sensitivity.x;

int isSameNormal = (diffNormal.x + diffNormal.y) < 0.1;

// difference in depth

float diffDepth = abs(centerDepth - sampleDepth) * _Sensitivity.y;

// scale the required threshold by the distance

int isSameDepth = diffDepth < 0.1 * centerDepth;

// return:

// 1 - if normals and depth are similar enough

// 0 - otherwise

return isSameNormal * isSameDepth ? 1.0 : 0.0;

}

fixed4 fragRobertsCrossDepthAndNormal(v2f i) : SV_Target {

half4 sample1 = tex2D(_CameraDepthNormalsTexture, i.uv[1]);

half4 sample2 = tex2D(_CameraDepthNormalsTexture, i.uv[2]);

half4 sample3 = tex2D(_CameraDepthNormalsTexture, i.uv[3]);

half4 sample4 = tex2D(_CameraDepthNormalsTexture, i.uv[4]);

half edge = 1.0;

edge *= CheckSame(sample1, sample2);

edge *= CheckSame(sample3, sample4);

fixed4 withEdgeColor = lerp(_EdgeColor, tex2D(_MainTex, i.uv[0]), edge);

fixed4 onlyEdgeColor = lerp(_EdgeColor, _BackgroundColor, edge);

return lerp(withEdgeColor, onlyEdgeColor, _EdgeOnly);

}

ENDCG

Pass {

ZTest Always Cull Off ZWrite Off

CGPROGRAM

#pragma vertex vert

#pragma fragment fragRobertsCrossDepthAndNormal

ENDCG

}

}

FallBack Off

}

高斯模糊

模糊的实现有很多方法,例如均值模糊和中值模糊。均值模糊同样使用了卷积操作,它使用的卷积核中的各个元素值都相等,且加等于1,也就是说卷积后得到的像素值是其邻域内各个像素值的平均值。而中值模糊则是选择邻域内对所有像素排序后的中值替换掉原颜色。

高斯滤波

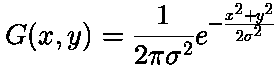

高斯模糊同样利用了卷积计算,它使用的卷积核名为高斯核。高斯核是一个正方形大小的滤波核,其中每个元素的计算都是基于下面的高斯方程:

其中,σ(sigma)是标准方差(一般取值为1),x和y分别对应了当前位置到卷积核中心的整数距离。

Bloom效果

Bloom特效是游戏中常见的一种屏幕效果。这种特效可以模拟真实摄像机的一种图像效果,它让画面中较亮的区域“扩散”到周围的区域中,造成一种朦胧的效果。

Bloom的实现原理

首先根据一个阈值提取出图像中的较亮区域,把它存储在一张渲染纹理中,再利用高斯模糊对这张渲染纹理进行模糊处理,模拟光线扩散效果,最后再将其和原图像进行混合,得到最终的效果。

Reference

《Shader入门精要》